La risposta dei governi ai rischi dell’AI

I governi di tutto il mondo stanno iniziando a considerare misure per proteggersi da questi scenari catastrofici. L’Unione Europea sta finalizzando un ampio atto sull’AI, la Casa Bianca dovrebbe presto emettere un ordine esecutivo mirato ai modelli di grandi dimensioni (LLMs), e il governo britannico ha convocato leader mondiali e capi della tecnologia per un “AI Safety Summit” per discutere i rischi estremi che i modelli di AI possono presentare. È essenziale che i regolatori agiscano con prudenza, evitando di creare regole e istituzioni globali inefficaci o che soffochino l’innovazione.

La necessità di una ricerca approfondita

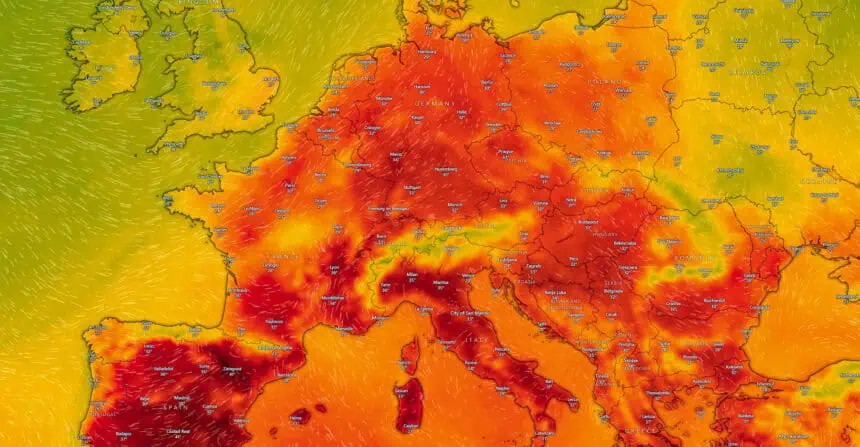

Prima di poter stabilire standard e regole, è necessaria una ricerca approfondita. Alcuni dirigenti tecnologici suggeriscono la creazione di un organismo per studiare l’AI simile al Panel Intergovernativo sul Cambiamento Climatico (IPCC), che monitora e spiega il riscaldamento globale. Questo aiuterebbe a stabilire cosa si considera rischioso e a valutare i modelli rispetto a un benchmark per il pericolo.

Regolamentazione prematura e innovazione

Una regolamentazione affrettata potrebbe distogliere l’attenzione dai problemi meno apocalittici ma più urgenti, come la gestione dei materiali protetti da copyright durante l’addestramento degli LLMs o la definizione dei diritti alla privacy. Inoltre, l’AI renderà molto più facile produrre disinformazione, un problema spinoso per ogni società.

Concorrenza e innovazione a rischio

Solo un numero limitato di aziende ha sviluppato finora modelli “frontier” potenti, a causa delle risorse informatiche e delle competenze tecniche richieste. Una nuova regolamentazione potrebbe facilmente rafforzare le posizioni degli attuali leader di mercato e bloccare i concorrenti, soprattutto perché i maggiori produttori di modelli stanno lavorando a stretto contatto con i governi nella stesura delle regole. Una concentrazione sui rischi estremi potrebbe rendere i regolatori diffidenti nei confronti dei modelli open-source, che sono liberamente disponibili e facilmente modificabili.

La necessità di un approccio ponderato

I regolatori devono essere pronti a reagire rapidamente se necessario, ma non dovrebbero essere affrettati nel definire regole o costruire istituzioni che potrebbero rivelarsi inutili o dannose. Attualmente, si sa troppo poco sulla direzione dell’AI generativa per comprendere i rischi associati, figuriamoci gestirli. Il meglio che i governi possano fare ora è istituire l’infrastruttura per studiare la tecnologia e i suoi potenziali pericoli, assicurando che coloro che lavorano al problema abbiano risorse adeguate.

In conclusione, mentre l’AI continua a svilupparsi, i regolatori avranno un’idea molto più chiara dei rischi da cui si stanno proteggendo e, di conseguenza, di come dovrebbe essere il libro delle regole. Un regime completamente sviluppato potrebbe alla fine assomigliare a quelli per altre tecnologie di importanza mondiale, come l’energia nucleare o l’ingegneria biologica. Tuttavia, la sua creazione richiederà tempo e riflessione.